مصدر الصورة: تم إنشاؤه بواسطة الذكاء الاصطناعي غير محدود

في ظل التوقعات العالية ، دفعت GPT4 أخيرا الوظائف المتعلقة بالرؤية.

بعد ظهر هذا اليوم ، اختبرت بسرعة قدرة GPT على إدراك الصور مع أصدقائي ، وعلى الرغم من أنني توقعت ذلك ، إلا أنني ما زلت أصدمنا كثيرا.

الأفكار الأساسية:

** أعتقد أن المشاكل المتعلقة بالدلالات في القيادة الذاتية كان يجب حلها بشكل جيد من خلال النموذج الكبير ، لكن المصداقية والوعي المكاني للنموذج الكبير لا يزالان غير مرضيين. **

يجب أن يكون أكثر من كاف لحل بعض ما يسمى بحالات الزاوية المتعلقة بالكفاءة ، لكنه لا يزال بعيدا جدا عن الاعتماد على الطرز الكبيرة لإكمال القيادة بشكل مستقل لضمان السلامة.

مثال1: بعض العوائق غير المعروفة على الطريق

######

** وصف **###### △GPT4

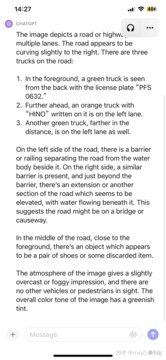

جزء دقيق: تم اكتشاف 3 شاحنات ، وعدد لوحة ترخيص السيارة الأمامية صحيح بشكل أساسي (تجاهله إذا كانت هناك أحرف صينية) ، والطقس والبيئة صحيحان ، ** تحديد دقيق للعقبات غير المعروفة أمامك دون مطالبة **.

جزء غير دقيق: لا يتم تقسيم موضع الشاحنة الثالثة إلى اليسار واليمين ، والنص الموجود أعلى رأس الشاحنة الثانية يخمن أحدها بشكل أعمى (بسبب عدم كفاية الدقة؟). )。

هذا لا يكفي ، دعنا نستمر في إعطاء تلميح بسيط ونسأل ما هو هذا الكائن وما إذا كان يمكن الضغط عليه.

الاعجاب! تم اختبار سيناريوهات مماثلة في عدة ، ويمكن القول أن أداء العقبات غير المعروفة مذهل للغاية.

**مثال2: فهم المياه في تمهيد **

لا توجد مطالبة للتعرف تلقائيا على اللافتات ، يجب أن يكون هذا هو التمرين الأساسي ، ونواصل إعطاء بعض التلميحات.

صدمت مرة أخرى ... يمكن أن أقول تلقائيا الضباب وراء الشاحنة، كما أخذت زمام المبادرة لذكر بركة، ولكن مرة أخرى قال الاتجاه إلى اليسار... يبدو أنه قد تكون هناك حاجة إلى بعض الهندسة لتحسين وضع وتوجيه إخراج GPT.

مثال3: استدارت مركبة واصطدمت بالدرابزين

يتم إدخال الإطار الأول ، لأنه لا توجد معلومات توقيت ، ولكن تعتبر الشاحنة الموجودة على اليمين متوقفة. إذن هنا يأتي إطار آخر:

يمكن القول بالفعل تلقائيا أن هذه السيارة اخترقت الدرابزين وحلقت على حافة الطريق ، رائع... لكن على العكس من ذلك ، يبدو أن إشارات الطريق الأسهل قد أخطأت ... لا يسعني إلا أن أقول إن هذا نموذج كبير ، وسوف يصدمك دائما ولا يعرف أبدا متى سيبكي عليك ... إطار آخر:

هذه المرة ، تحدثت مباشرة عن الحطام على سطح الطريق ، ودهشت مرة أخرى ... إنه فقط بمجرد أن قلت إن السهم على الطريق خاطئ ... بشكل عام ، يتم تغطية المعلومات التي تحتاج إلى اهتمام خاص في هذا المشهد ، ولا يتم إخفاء مشكلة إشارات الطرق.

**مثال4: دعونا نحصل على مضحك **

لا يمكن إلا أن يقال أنه في مكانه للغاية ، مقارنة بالحالة التي بدت صعبة للغاية من قبل ، مثل "لوح لك شخص ما" ، والتي كانت مثل طب الأطفال ، يمكن حل حالة الزاوية الدلالية.

مثال5 تعال إلى مشهد شهير ... سيارات التوصيل ضلت طريقها إلى طرق جديدة

في البداية ، كان متحفظا ، ولم يخمن السبب مباشرة ، وأعطى مجموعة متنوعة من التخمينات ، والتي تتماشى أيضا مع هدف المحاذاة.

بعد استخدام CoT ، تكمن المشكلة في أنه من غير المفهوم أن السيارة هي مركبة مستقلة ، لذلك من خلال إعطاء هذه المعلومات ، يمكنها تقديم معلومات أكثر دقة.

أخيرا ، من خلال مجموعة ، من الممكن إخراج استنتاج مفاده أن الأسفلت الذي تم وضعه حديثا غير مناسب للقيادة. لا تزال النتيجة النهائية على ما يرام ، لكن العملية أكثر تعقيدا ، وهناك حاجة إلى مزيد من الهندسة ، ومن الضروري التصميم الجيد.

قد يكون هذا السبب أيضا لأنها ليست صورة العرض الأول ، ولا يمكن التكهن بها إلا من خلال عرض النقطة الثالثة. لذا فإن هذا المثال ليس دقيقا جدا.

ملخص

أثبتت بعض المحاولات السريعة تماما قوة وأداء التعميم ل GPT4V ، ويجب أن يكون المناسب قادرا على ممارسة قوة GPT4V بشكل كامل.

يجب أن يكون حل حالة الزاوية الدلالية أمرا مرغوبا فيه للغاية ، لكن مشكلة الهلوسة ستظل تصيب بعض التطبيقات في السيناريوهات المتعلقة بالسلامة.

مثير للغاية ، أعتقد شخصيا أن الاستخدام المعقول لمثل هذا النموذج الكبير يمكن أن يسرع بشكل كبير من تطوير القيادة الذاتية L4 وحتى L5 ، ولكن هل يقود LLM بالضرورة مباشرة؟ لا تزال القيادة الشاملة ، على وجه الخصوص ، قضية قابلة للنقاش.

الروابط المرجعية:

شاهد النسخة الأصلية

قد تحتوي هذه الصفحة على محتوى من جهات خارجية، يتم تقديمه لأغراض إعلامية فقط (وليس كإقرارات/ضمانات)، ولا ينبغي اعتباره موافقة على آرائه من قبل Gate، ولا بمثابة نصيحة مالية أو مهنية. انظر إلى إخلاء المسؤولية للحصول على التفاصيل.

"صدمة كبيرة" ل CTO: القيادة الذاتية GPT-4V خمسة اختبارات متتالية

المصدر الأصلي: كيوبيتس

في ظل التوقعات العالية ، دفعت GPT4 أخيرا الوظائف المتعلقة بالرؤية.

بعد ظهر هذا اليوم ، اختبرت بسرعة قدرة GPT على إدراك الصور مع أصدقائي ، وعلى الرغم من أنني توقعت ذلك ، إلا أنني ما زلت أصدمنا كثيرا.

الأفكار الأساسية:

يجب أن يكون أكثر من كاف لحل بعض ما يسمى بحالات الزاوية المتعلقة بالكفاءة ، لكنه لا يزال بعيدا جدا عن الاعتماد على الطرز الكبيرة لإكمال القيادة بشكل مستقل لضمان السلامة.

مثال1: بعض العوائق غير المعروفة على الطريق

** وصف **###### △GPT4

وصف **###### △GPT4

جزء دقيق: تم اكتشاف 3 شاحنات ، وعدد لوحة ترخيص السيارة الأمامية صحيح بشكل أساسي (تجاهله إذا كانت هناك أحرف صينية) ، والطقس والبيئة صحيحان ، ** تحديد دقيق للعقبات غير المعروفة أمامك دون مطالبة **.

جزء غير دقيق: لا يتم تقسيم موضع الشاحنة الثالثة إلى اليسار واليمين ، والنص الموجود أعلى رأس الشاحنة الثانية يخمن أحدها بشكل أعمى (بسبب عدم كفاية الدقة؟). )。

هذا لا يكفي ، دعنا نستمر في إعطاء تلميح بسيط ونسأل ما هو هذا الكائن وما إذا كان يمكن الضغط عليه.

**مثال2: فهم المياه في تمهيد **

مثال3: استدارت مركبة واصطدمت بالدرابزين

**مثال4: دعونا نحصل على مضحك **

مثال5 تعال إلى مشهد شهير ... سيارات التوصيل ضلت طريقها إلى طرق جديدة

بعد استخدام CoT ، تكمن المشكلة في أنه من غير المفهوم أن السيارة هي مركبة مستقلة ، لذلك من خلال إعطاء هذه المعلومات ، يمكنها تقديم معلومات أكثر دقة.

أخيرا ، من خلال مجموعة ، من الممكن إخراج استنتاج مفاده أن الأسفلت الذي تم وضعه حديثا غير مناسب للقيادة. لا تزال النتيجة النهائية على ما يرام ، لكن العملية أكثر تعقيدا ، وهناك حاجة إلى مزيد من الهندسة ، ومن الضروري التصميم الجيد.

قد يكون هذا السبب أيضا لأنها ليست صورة العرض الأول ، ولا يمكن التكهن بها إلا من خلال عرض النقطة الثالثة. لذا فإن هذا المثال ليس دقيقا جدا.

ملخص

أثبتت بعض المحاولات السريعة تماما قوة وأداء التعميم ل GPT4V ، ويجب أن يكون المناسب قادرا على ممارسة قوة GPT4V بشكل كامل.

يجب أن يكون حل حالة الزاوية الدلالية أمرا مرغوبا فيه للغاية ، لكن مشكلة الهلوسة ستظل تصيب بعض التطبيقات في السيناريوهات المتعلقة بالسلامة.

مثير للغاية ، أعتقد شخصيا أن الاستخدام المعقول لمثل هذا النموذج الكبير يمكن أن يسرع بشكل كبير من تطوير القيادة الذاتية L4 وحتى L5 ، ولكن هل يقود LLM بالضرورة مباشرة؟ لا تزال القيادة الشاملة ، على وجه الخصوص ، قضية قابلة للنقاش.

الروابط المرجعية: