Di bawah harapan yang tinggi, GPT4 akhirnya mendorong fungsi terkait penglihatan.

Sore ini, saya dengan cepat menguji kemampuan GPT untuk melihat gambar dengan teman-teman saya, dan meskipun saya mengharapkannya, saya masih sangat mengejutkan kami.

Ide inti:

** Saya pikir masalah terkait semantik dalam mengemudi otonom seharusnya diselesaikan dengan baik oleh model besar, tetapi kredibilitas dan kesadaran spasial dari model besar masih belum memuaskan. **

Seharusnya lebih dari cukup untuk menyelesaikan beberapa yang disebut kasus sudut terkait efisiensi, tetapi masih sangat jauh dari mengandalkan model besar untuk menyelesaikan mengemudi secara mandiri untuk memastikan keselamatan.

Contoh1: Beberapa rintangan yang tidak diketahui di jalan

######

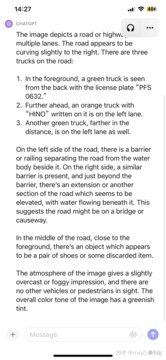

** Deskripsi **###### △GPT4

Bagian yang akurat: 3 truk terdeteksi, nomor plat mobil depan pada dasarnya benar (abaikan saja jika ada karakter Cina), cuaca dan lingkungan benar, ** Identifikasi akurat dari rintangan yang tidak diketahui di depan tanpa diminta **.

Bagian yang tidak akurat: posisi truk ketiga tidak dibagi kiri dan kanan, dan teks di bagian atas kepala truk kedua menebak satu secara membabi buta (karena resolusi yang tidak memadai?). )。

Itu tidak cukup, mari kita terus memberi sedikit petunjuk dan bertanya apa objek ini dan apakah bisa ditekan.

Mengesankan! Skenario serupa telah diuji dalam beberapa hal, dan kinerja rintangan yang tidak diketahui dapat dikatakan sangat menakjubkan.

Contoh2: Pengertian Air di Pave

Tidak ada prompt untuk secara otomatis mengenali signage, ini harus menjadi latihan dasar, kami terus memberikan beberapa petunjuk.

Terkejut lagi... Secara otomatis dapat mengetahui kabut di belakang truk, juga berinisiatif menyebutkan genangan air, tetapi sekali lagi mengatakan arah ke kiri ... Rasanya seperti beberapa rekayasa mungkin diperlukan untuk memposisikan dan mengarahkan output GPT dengan lebih baik.

Contoh3: Sebuah kendaraan berbalik arah dan menabrak pagar pembatas

Bingkai pertama dimasukkan, karena tidak ada informasi waktu, tetapi truk di sebelah kanan dianggap berhenti. Jadi inilah bingkai lain:

Secara otomatis bisa dikatakan bahwa mobil ini menerobos pagar pembatas dan melayang di pinggir jalan, fantastis ... Tetapi sebaliknya, tampaknya rambu-rambu jalan yang lebih mudah telah salah ... Saya hanya bisa mengatakan bahwa ini adalah model besar, itu akan selalu mengejutkan Anda dan tidak pernah tahu kapan akan menangis konyol Anda ... Satu bingkai lagi:

Kali ini, saya berbicara langsung tentang puing-puing di permukaan jalan, dan saya kagum lagi ... Hanya saja begitu saya salah mengatakan panah di jalan ... Secara keseluruhan, informasi yang perlu perhatian khusus dalam adegan ini tercakup, dan masalah rambu-rambu jalan tidak disembunyikan.

Contoh4: Mari kita lucu

Hanya dapat dikatakan bahwa itu sangat pada tempatnya, dibandingkan dengan kasus yang tampaknya sangat sulit sebelumnya, seperti "seseorang melambai padamu", yang seperti pediatri, kasus sudut semantik dapat diselesaikan.

Contoh5 Datang ke adegan terkenal ... Kendaraan pengiriman tersesat ke jalan baru

Pada awalnya, itu konservatif, dan tidak langsung menebak alasannya, memberikan berbagai tebakan, yang juga sejalan dengan tujuan penyelarasan.

Setelah menggunakan CoT, masalah yang ditemukan adalah tidak dipahami bahwa mobil tersebut adalah kendaraan otonom, sehingga dengan memberikan informasi ini, dapat memberikan informasi yang lebih akurat.

Akhirnya, melalui banyak, dimungkinkan untuk menghasilkan kesimpulan bahwa aspal yang baru diletakkan tidak cocok untuk dikendarai. Hasil akhirnya masih oke, tetapi prosesnya lebih berliku-liku, dan diperlukan lebih banyak teknik, dan perlu dirancang dengan baik.

Alasan ini mungkin juga karena ini bukan gambar tampilan pertama, dan hanya dapat berspekulasi melalui tampilan titik ketiga. Jadi contoh ini tidak terlalu tepat.

Ringkasan

Beberapa upaya cepat telah sepenuhnya membuktikan kekuatan dan kinerja generalisasi GPT4V, dan yang sesuai harus dapat sepenuhnya mengerahkan kekuatan GPT4V.

Memecahkan kasus sudut semantik harus sangat diinginkan, tetapi masalah halusinasi masih akan mengganggu beberapa aplikasi dalam skenario terkait keselamatan.

Sangat menarik, saya pribadi berpikir bahwa penggunaan yang wajar dari model sebesar itu dapat sangat mempercepat pengembangan mengemudi otonom L4 dan bahkan L5, tetapi apakah LLM harus mengemudi secara langsung? Mengemudi ujung ke ujung, khususnya, tetap menjadi masalah yang bisa diperdebatkan.

Link Referensi:

Lihat Asli

Halaman ini mungkin berisi konten pihak ketiga, yang disediakan untuk tujuan informasi saja (bukan pernyataan/jaminan) dan tidak boleh dianggap sebagai dukungan terhadap pandangannya oleh Gate, atau sebagai nasihat keuangan atau profesional. Lihat Penafian untuk detailnya.

"Kejutan besar" dari CTO: GPT-4V mengemudi otonom lima tes berturut-turut

Sumber asli: Qubits

Di bawah harapan yang tinggi, GPT4 akhirnya mendorong fungsi terkait penglihatan.

Sore ini, saya dengan cepat menguji kemampuan GPT untuk melihat gambar dengan teman-teman saya, dan meskipun saya mengharapkannya, saya masih sangat mengejutkan kami.

Ide inti:

Seharusnya lebih dari cukup untuk menyelesaikan beberapa yang disebut kasus sudut terkait efisiensi, tetapi masih sangat jauh dari mengandalkan model besar untuk menyelesaikan mengemudi secara mandiri untuk memastikan keselamatan.

Contoh1: Beberapa rintangan yang tidak diketahui di jalan

** Deskripsi **###### △GPT4

Deskripsi **###### △GPT4

Bagian yang akurat: 3 truk terdeteksi, nomor plat mobil depan pada dasarnya benar (abaikan saja jika ada karakter Cina), cuaca dan lingkungan benar, ** Identifikasi akurat dari rintangan yang tidak diketahui di depan tanpa diminta **.

Bagian yang tidak akurat: posisi truk ketiga tidak dibagi kiri dan kanan, dan teks di bagian atas kepala truk kedua menebak satu secara membabi buta (karena resolusi yang tidak memadai?). )。

Itu tidak cukup, mari kita terus memberi sedikit petunjuk dan bertanya apa objek ini dan apakah bisa ditekan.

Contoh2: Pengertian Air di Pave

Contoh3: Sebuah kendaraan berbalik arah dan menabrak pagar pembatas

Contoh4: Mari kita lucu

Contoh5 Datang ke adegan terkenal ... Kendaraan pengiriman tersesat ke jalan baru

Setelah menggunakan CoT, masalah yang ditemukan adalah tidak dipahami bahwa mobil tersebut adalah kendaraan otonom, sehingga dengan memberikan informasi ini, dapat memberikan informasi yang lebih akurat.

Akhirnya, melalui banyak, dimungkinkan untuk menghasilkan kesimpulan bahwa aspal yang baru diletakkan tidak cocok untuk dikendarai. Hasil akhirnya masih oke, tetapi prosesnya lebih berliku-liku, dan diperlukan lebih banyak teknik, dan perlu dirancang dengan baik.

Alasan ini mungkin juga karena ini bukan gambar tampilan pertama, dan hanya dapat berspekulasi melalui tampilan titik ketiga. Jadi contoh ini tidak terlalu tepat.

Ringkasan

Beberapa upaya cepat telah sepenuhnya membuktikan kekuatan dan kinerja generalisasi GPT4V, dan yang sesuai harus dapat sepenuhnya mengerahkan kekuatan GPT4V.

Memecahkan kasus sudut semantik harus sangat diinginkan, tetapi masalah halusinasi masih akan mengganggu beberapa aplikasi dalam skenario terkait keselamatan.

Sangat menarik, saya pribadi berpikir bahwa penggunaan yang wajar dari model sebesar itu dapat sangat mempercepat pengembangan mengemudi otonom L4 dan bahkan L5, tetapi apakah LLM harus mengemudi secara langsung? Mengemudi ujung ke ujung, khususnya, tetap menjadi masalah yang bisa diperdebatkan.

Link Referensi: